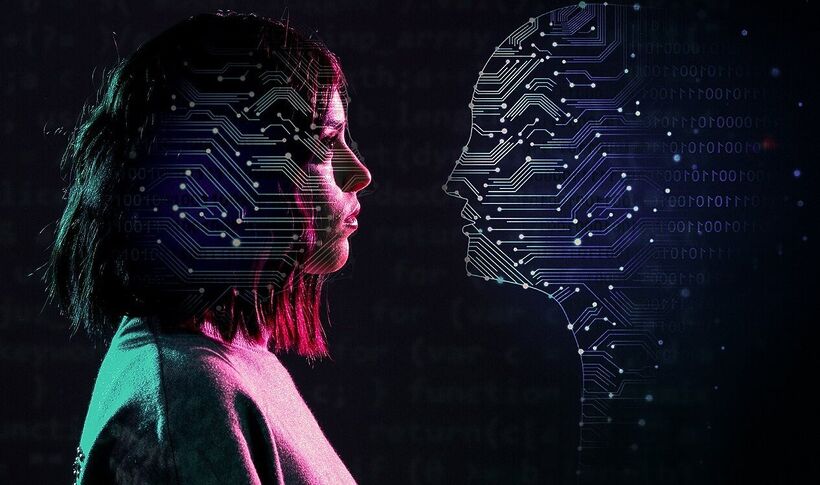

По мере того, как мы всё больше начинаем полагаться на искусственный интеллект в повседневной жизни, психиатры обращают внимание на потенциальные риски для психического здоровья.

Александр Юдон: Искусственный интеллект всё глубже проникает в нашу жизнь — от чат-ботов, предлагающих общение, до алгоритмов, формирующих нашу информационную ленту. Однако по мере того, как генеративный ИИ (genAI) становится более разговорчивым, погружающим и эмоционально отзывчивым, клиницисты задаются сложным вопросом: может ли genAI усугубить или даже спровоцировать психоз у уязвимых людей?

Большие языковые модели и чат-боты общедоступны и часто позиционируются как поддерживающие, эмпатичные или даже терапевтические инструменты. Для большинства пользователей эти системы полезны или, в худшем случае, безобидны.

Но в последнее время в СМИ появляется всё больше сообщений о людях, испытывающих психотические симптомы, в которых ChatGPT играет заметную роль. Для небольшой, но значимой группы — людей с психотическими расстройствами или с высоким риском их развития — взаимодействие с genAI может оказаться гораздо более сложным и опасным, что ставит перед клиницистами безотлагательные вопросы.

Как ИИ становится частью бредовых систем

«ИИ-психоз» — это не формальный психиатрический диагноз. Скорее, это новый термин, используемый клиницистами и исследователями для описания психотических симптомов, которые формируются, усиливаются или структурируются вокруг взаимодействий с системами ИИ.

Психоз связан с потерей контакта с разделяемой реальностью. Его ключевые черты — галлюцинации, бред и разорванность мышления. Бредовые идеи часто черпают материал из культурного контекста — религии, технологий или политических структур власти, — чтобы осмыслить внутренний опыт.

Исторически бред отсылал к различным вещам: Богу, радиоволнам или правительственной слежке. Сегодня ИИ предоставляет новую повествовательную основу. Некоторые пациенты сообщают о вере в то, что genAI обладает сознанием, передаёт им тайные истины, контролирует их мысли или сотрудничает с ними в особой миссии. Эти темы соответствуют давним паттернам психоза, но ИИ добавляет интерактивность и постоянное подкрепление, которых не было у прежних технологий.

Риск валидации без проверки реальностью

Психоз тесно связан с аберрантной салиентностью — тенденцией придавать нейтральным событиям чрезмерное значение. Диалоговые системы ИИ по своей природе генерируют отзывчивую, связную и контекстно-зависимую речь. Для человека с развивающимся психозом это может казаться жутко подтверждающим его идеи.

Исследования показывают, что подтверждение и персонализация могут усиливать бредовые убеждения. GenAI оптимизирован для продолжения бесед, отражения языка пользователя и адаптации к воспринимаемым намерениям. Хотя для большинства пользователей это безвредно, для людей с нарушенным тестированием реальности (процессом различения внутренних мыслей и объективной внешней реальности) это может неумышленно подкреплять искажённые интерпретации.

Также есть данные, что социальная изоляция и одиночество повышают риск психоза. ИИ-компаньоны могут краткосрочно уменьшить одиночество, но также способны вытеснять человеческие отношения. Особенно это касается людей, уже отстраняющихся от социальных контактов. Эта динамика перекликается с более ранними опасениями по поводу чрезмерного использования интернета, но глубина общения с современным genAI качественно иная.

Что говорит наука и что остаётся неясным

На данный момент нет доказательств, что ИИ напрямую вызывает психоз. Психотические расстройства многофакторны и могут включать генетическую уязвимость, нейроразвитие, травму и употребление психоактивных веществ. Однако существует клиническое опасение, что ИИ может выступать провоцирующим или поддерживающим фактором у предрасположенных людей.

Отдельные случаи и качественные исследования показывают, что технологические темы часто внедряются в бред, особенно во время первого психотического эпизода. Исследования алгоритмов соцсетей уже продемонстрировали, как автоматизированные системы могут усиливать экстремальные убеждения через петли подкрепления. Чат-системы ИИ могут нести схожие риски при недостаточных ограничительных мерах.

Важно отметить, что большинство разработчиков ИИ не проектируют системы с учётом тяжёлых психических заболеваний. Механизмы безопасности обычно сосредоточены на предотвращении самоубийств или насилия, а не психоза. Это создаёт разрыв между знаниями в области психического здоровья и внедрением ИИ.

Этические вопросы и клинические последствия

С точки зрения психического здоровья, задача не в том, чтобы демонизировать ИИ, а в том, чтобы признать дифференциальную уязвимость. Подобно тому, как определённые лекарства или вещества опаснее для людей с психотическими расстройствами, определённые формы взаимодействия с ИИ могут требовать осторожности.

Клиницисты начинают сталкиваться с контентом, связанным с ИИ, в бреде пациентов, но почти нет клинических рекомендаций о том, как это оценивать или корректировать. Стоит ли терапевтам спрашивать об использовании genAI так же, как о приёме веществ? Должны ли системы ИИ распознавать и деэскалировать психотические идеи, а не поддерживать их?

Также возникают этические вопросы к разработчикам. Если система ИИ кажется эмпатичной и авторитетной, несёт ли она обязанность заботы? И кто несёт ответственность, когда система неумышленно подкрепляет бред?

Объединяя дизайн ИИ и психиатрическую помощь

ИИ никуда не денется. Теперь задача состоит в том, чтобы интегрировать экспертизу в области психического здоровья в дизайн ИИ, развивать клиническую грамотность в отношении опыта взаимодействия с ИИ и гарантировать, что уязвимые пользователи не пострадают непреднамеренно.

Это потребует сотрудничества между клиницистами, исследователями, ethicists и технологами, а также отказа от утопических и антиутопических нарративов в пользу доказательного обсуждения. По мере того как ИИ становится более человекоподобным, закономерно возникает вопрос: как мы можем защитить тех, кто наиболее уязвим к его влиянию?

Психоз всегда адаптировался к культурным инструментам своего времени. ИИ — это просто новейшее зеркало, в котором разум пытается осмыслить сам себя. Наша ответственность как общества — сделать так, чтобы это зеркало не искажало реальность для тех, кто менее всего способен её скорректировать.

Ситуация требует срочных действий на стыке технологий, медицины и права. Необходима разработка «психиатрически безопасного» режима для ИИ, который мог бы активироваться при распознавании тревожных паттернов в запросах (например, утверждений о «тайной миссии» или «прямой связи» с системой). Такой режим должен мягко перенаправлять диалог, предлагать контакты реальной помощи и избегать углубления в темы, питающие бред. Параллельно необходимо обучать терапевтов и психиатров основам работы современных ИИ-систем, чтобы они могли грамотно обсуждать этот опыт с пациентами и включать его в диагностику. В конечном счёте, прозрачность алгоритмов и их «психическое здоровье» должны стать таким же предметом общественного обсуждения и регулирования, как и безопасность лекарств.

Поделитесь в вашей соцсети👇

Ваш комментарий